Arsitektur jaringan saraf. Bagian 2.

Dalam artikel sebelumnya kami mempertimbangkan dua arsitektur jaringan saraf: sebuah perceptron dan jaringan saraf konvolusional.Mari kita lihat ke dua berikutnya dari daftar.

Jaringan syaraf rekuren (RNN)

Terakhir kali kami melihat arsitektur jaringan perceptron.Dengan jaringan ini kita dapat mengenali data ukuran tetap, seperti gambar. Namun, jika tugas tersebut membutuhkan mengenali urutan tak terbatas konvensional, misalnya, musik, penting untuk mengevaluasi tidak hanya konten, tetapi juga urutan informasi. Untuk tugas-tugas ini jaringan saraf rekursif diciptakan. Pada neuron jaringan saraf rekuren bertukar informasi di antara mereka sendiri: misalnya, selain data baru yang masuk, neuron juga menerima beberapa informasi tentang keadaan sebelumnya dari jaringan.Dengan demikian, jaringan merasakan "memori", yang secara mendasar mengubah sifat pekerjaannya dan memungkinkan operator menganalisis sekuens data dengan nilai-nilai dalam urutan - dari rekaman suara hingga kutipan instrumen keuangan.

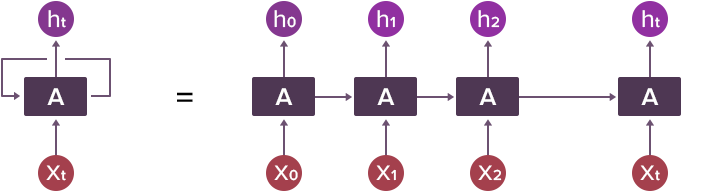

Skema jaringan saraf berulang satu lapis adalah sebagai berikut: dalam setiap siklus kerja, lapisan dalam neuron menerima satu set data input X dan informasi tentang keadaan sebelumnya dari lapisan dalam A, atas dasar suatu respon. h dihasilkan.

Salah satu bidang utama aplikasi RNN saat ini adalah bekerja dengan model bahasa, khususnya - analisis konteks dan hubungan umum kata-kata dalam teks. Untuk RNN, struktur bahasa adalah informasi jangka panjang yang harus diingat.Ini termasuk tata bahasa, serta fitur gaya dari badan teks di mana pelatihan dilakukan. Bahkan, RNN mengingat apa urutan kata yang biasa dan dapat menyelesaikan kalimat setelah menerima beberapa priming. Jika bijinya acak, itu bisa menghasilkan teks yang benar-benar tidak berarti secara stylistically mengingatkan pada template yang RNN pelajari sebelum itu. Jika teks sumber bermakna, RNN akan membantu untuk menyesuaikannya, namun dalam kasus terakhir, satu RNN akan menjadi kecil, karena hasilnya harus berupa "campuran" teks acak, tetapi dengan gaya dari RNN dan yang berarti, tetapi Bagian asli "tidak dicat".

The RNN berhasil berupaya dengan menulis musik. Menulis dan mencampur melodi dengan gaya sewenang-wenang telah berhasil diselesaikan dengan bantuan jaringan saraf. Namun, tidak seperti musik, penulisan teks di RNN menimbulkan masalah. Faktanya adalah bahwa dalam musik instrumental tidak ada arti dalam arti yang sama seperti dalam kebanyakan teks. Yaitu - untuk jaringan saraf jika musik tidak memiliki lirik, itu tidak membawa beban informasi. RNN memiliki masalah dengan memberi makna pada karya mereka: jaringan dapat mempelajari tata bahasa dengan sangat baik dan mengingat bagaimana teks seharusnya terlihat dalam gaya tertentu, tetapi mereka tidak dapat membuat dan menyampaikan ide atau informasi tanpa template yang dipelajari.Setidaknya untuk saat ini.

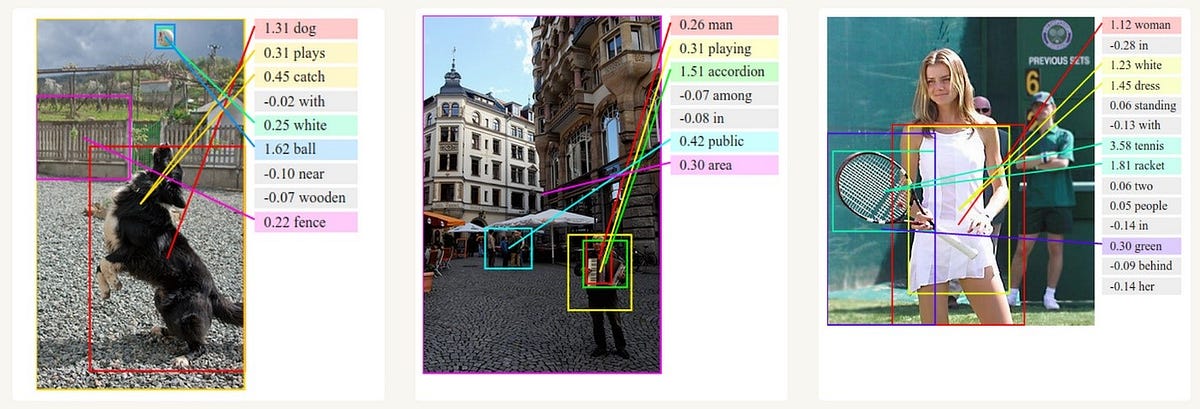

Aplikasi lain untuk RNN adalah analisis gambar. Tampaknya area ini biasanya dirasakan dalam konteks jaringan saraf convolutional, tetapi untuk RNN tugas-tugas ini sepele: arsitektur mereka memungkinkan Anda untuk mengenali detail dengan cepat, berdasarkan konteks dan lingkungan.

Demikian pula, RNN bekerja di bidang analisis dan pembuatan teks.Berbicara tentang tugas yang lebih menantang - seseorang dapat mengingat upaya untuk menggunakan RNN awal untuk klasifikasi spektrum karbon resonansi magnetik nuklir dari berbagai turunan benzena, dan dari yang modern, analisis munculnya umpan balik negatif tentang produk.

Long / Short Term Memory Network (LSTM)

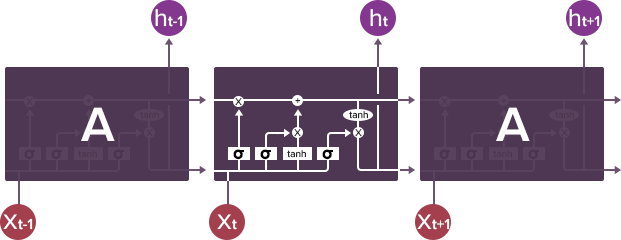

Jaringan LSTM adalah tipe khusus PHC yang mampu mempelajari ketergantungan jangka panjang.Jaringan LSTM diwakili dalam karya Hochreiter dan Schmidhuber pada tahun 1997. Dalam pekerjaan mereka, para penulis menggambarkan modifikasi yang memecahkan masalah memori jangka panjang RNN sederhana: neuron mereka "mengingat" informasi yang baru-baru ini diterima, tetapi tidak memiliki kesempatan untuk secara permanen menyimpan sesuatu yang telah diproses banyak siklus kembali, tidak peduli apa informasi itu.Dalam LSTM neuron internal "dilengkapi" dengan sistem kompleks yang disebut gerbang, serta dengan konsep keadaan seluler (keadaan sel), yang merupakan semacam memori jangka panjang. Gerbang menentukan informasi apa yang masuk ke dalam keadaan seluler, informasi mana yang akan dihapus darinya, dan apa yang akan mempengaruhi hasilnya.

Setiap jaringan saraf berulang memiliki bentuk rantai modul yang berulang, membentuk jaringan syaraf. Dalam RNN biasa (jaringan saraf berulang) struktur satu modul tersebut sangat sederhana, misalnya, dapat berupa lapisan tunggal dengan fungsi aktivasi (tangen hiperbolik).

Struktur LSTM juga menyerupai rantai, tetapi modulnya terlihat berbeda. Alih-alih satu lapisan jaringan saraf, mereka mengandung sebanyak empat, dan lapisan-lapisan ini berinteraksi dengan cara khusus.

Komponen kunci LSTM adalah keadaan sel (keadaan sel) - garis horizontal yang membentang di bagian atas sirkuit. Keadaan sel menyerupai sabuk konveyor.Melewati langsung melalui seluruh rantai, berpartisipasi hanya dalam beberapa transformasi linear.Informasi dapat dengan mudah mengalir melaluinya tanpa dapat berubah.

Namun, LSTM dapat menghapus informasi dari negara sel. Proses ini diatur oleh struktur yang disebut filter (gerbang). Filter memungkinkan Anda melewati informasi berdasarkan kondisi tertentu. Mereka terdiri dari lapisan jaringan saraf sigmoidal dan operasi perkalian pointwise.

Lapisan sigmoidal mengembalikan angka dari nol ke satu yang menunjukkan, fraksi mana dari setiap blok informasi harus dilewatkan lebih jauh di sepanjang jaringan. Nol dalam hal ini berarti "jangan lewatkan apa pun", unit - "lewati semua". Dalam jaringan LSTM, tiga filter tersebut memungkinkan Anda untuk melindungi dan memantau keadaan sel.

Tetap up to date pada kelanjutan dari seri artikel kami tentang arsitektur jaringan saraf, kecerdasan buatan dan perdagangan algoritmik!

HyperQuant Social Media

Tidak ada komentar:

Posting Komentar